요 약

모션 캡춰 카메라로 전환되는 감각의 인터랙션을 통해 능동적으로 공간음향을 연출하고 무대기술 일치화로 감흥과 몰입을 향상시켜 예술적 표현과 가치를 높이고자 하는 것이 주 연구 내용이다. 그 결과를 토대로 이 기술이 활용될 수 있는 분야와 이를 효과적으로 적용할 수 있는 방법에 대해 기술하고자 한다.

1. 서 론

인간이 가지고 있는 감각은 상호작용하며 이런 현상은 멀티미디어 기술과 융합되어 인터렉티브 미디어아트의 예술 작품에 응용되기도 한다. 이번 연구는 이러한 다중감각의 전이와 상호작용을 응용하여 공간음향의 연출에 활용할 수 있는 방법에 대한 고찰이다. 이를 위해 우리가 가장 많이 사용하고 상호작용함을 쉽게 체감할 수 있는 감각 중 시감각과 청감각을 선택하고 이 두 감각을 전환할 수 있는 마이크로소프트의 애저 키넥트 DK 뎁스 카메라를 멀티미디어 매개체로 사용한다. 이것으로 분석한 특정 신체 관절의 좌표를 우리가 원하는 데이터로 변환하여 공간음향 연출에 활용하면 감각적 인지 효과를 높일 수 있으며 무대음향 기기, 무대조명 기기, 기타 프로그램 등의 제어에 응용할 수 있다.

감각의 전이를 응용하고 적용했던 미디어아트 작품의 기술을 사례로 이를 활용한 공간음향의 연출과 효과, 그리고 다양한 분야에서 적용할 수 있는 방법에 대해 기술하고자 한다.

2. 감각의 전이, 공감각(synesthesia)

인간은 시감각, 청감각, 미감각, 후감각, 촉감각의 5가지 감각이 있다. 감각은 각각 독립적으로 작용하지 않고 서로 상호작용하며 이 현상을 감각의 전이, 공감각이라고 한다.

공감각(Synesthesia)이란 감각을 공유한다는 뜻으로, ‘synesthesia’의 어원은 ‘syn-(with)’과 ‘aisthesia(sensation)’로 구성된 의미이다. 인간은 모두 다중감각자이다. 오감을 통해 외부의 물리적 자극을 받아들이고 이 정보를 뇌에서 처리한다. 이러한 입력과 중앙 처리 과정에서 특정 감각의 물리적 자극은 그에 대응하는 감각과 지각, 인지에만 영향을 미치는 것이 아니라, 다른 감각과 상호작용하며 통합적으로 인지한다. 1)

| 예시 | 전이 |

| 분수처럼 흩어지는 푸른 종소리 | 시감각 -> 청감각 |

| 캄캄한 공기를 마시면 | 미감각 -> 촉감각 |

| 이마에 시며드는 향료로운 자양 | 촉감각 -> 시감각 |

| 타오르는 꽃불도 향기론데 | 시감각 -> 후감각 |

| 수박 냄새 품어 오는 저녁 물바람 | 후감각 -> 촉감각 |

1) 양원영.(2018).[용어와 건축] 공감각, 그리고 다중감각의 상호작용.건축, 62(9), 64-64.

2) 윤홍노.(1970). 공감각 은유의 구조성 – 현대 한국시를 중심으로. 국어국 문학, 49·50, 183-200.

3. 공간 지각(Spatial Perception) 3)

소리로 공간을 지각하는 요소로는 수평각(Azimuth Angle)의 ITD(Interaural Time Difference)와 IID(Interaural Intensity Difference)가 있고, 수직각(Elevation Angle)의 귓바퀴 필터링 효과(Pinna Filtering Effect), 그리고 거리 지각의 SI(Sound Intensity)가 있다. 우리는 이 요소로 3D 공간 내에서 소리의 위치를 감지할 수 있다.

여기에서 아래의 표 2, 표 3, 표 4를 통해 이번 연구와 밀접한 관련이 있는 단서를 알게 되었는데 바로 수평 지각, 수직 지각, 거리 지각에서 모두 시각적인 단서가 위치 정보에 우선할 정도로 큰 영향을 미친다는 사실이다. 이것을 잘 활용하면 청각적 위치 정보를 더욱 뚜렷하게 할 수 있다. (clarify)

| 단서(CUE) | 원리 |

| 두 귀간 시간차 | 시간차, 또는 위상차가 630㎲ 까지는 선형적, 1ms이상 귀간 편이 없음 |

| 두 귀간 레벨차 | 10 ~ 15dB의 레벨 차는 한 쪽으로 이동 |

| 스펙트럼 | 500 ~ 800Hz 이하 대역 : ITD로 감지 800 ~ 1.5kHz 사이 대역 : ITD, IID 감지 1.5kHz 이상 대역 : IID로 감지 4) |

| 시각 작용 | 고막을 통해서 얻어진 음향 정보에는 전혀 관계없이 시각 정보가 우선한다. |

4)표 2. 수평 지각의 단서

| 단서(CUE) | 원리 |

| 귓바퀴 영향 | 앞 : 귓바퀴 난반사, 감쇄 많고 특이함, 지저분 하고 콤필터링 딥이 크다 위 : 귓바퀴 통과, 밋밋한 귓볼 반사, 감쇄 적고 밋밋함, 콤필터링 딥 적음 아래 : 귓볼 통과, 귓바퀴 반사, 감쇄 많지만 앞보다는 적음, 콤필터링 딥 적음 뒤 : 대부분 귓등 반사, 저음 회절, 고음 감쇄, 음량 감소, 콤필터링 딥 적음 |

| 머리의 영향 | 머리에 의한 음장의 산란 |

| 머리 움직임 | 움직임에 두 귀의 고막상의 신호 변화 |

| 골전도 | 고막 전달과 골전도 전달의 레벨차 40dB |

| 시각 작용 | 고막을 통해서 얻어진 음향 정보에는 전혀 관계없이 시각 정보가 우선한다. |

표3. 수직 지각의 단서

| 단서(CUE) | 원리 |

| 소리의 크기 | 역자승의 법칙에 의해 거리에 반비례 |

| 스펙트럼 | 음원이 가까워지면 음색이 어두워진다. 원거리는 고주파수 감쇠율 증가(공기 흡수) |

| 두 귀간 차 | 0 ~ 1m까지는 두 귀간 차이가 작아짐 1m 이상부터 차이를 못 느낌 |

| 반사음 | 직접음 대비 반사음으로 공간 및 거리 감지 |

| 시각 작용 | 고막을 통해서 얻어진 음향 정보에는 전혀 관계없이 시각 정보가 우선한다. |

표4. 거리 지각의 단서

3) 강성훈, 강경욱, 입체음향(Spatial Audio), 기전연구사(1997.7), 54-62

4) 최찬규, 이머시브 라이브 시스템 패닝 알고리즘, (사)무대음향협회 (2022.04). SSM Vol. 02, 54.

특히, ITD, IID, SI는 비교적 단순한 물리량의 변화(음량의 변화)로도 쉽게 체감되고 간단히 제어될 수 있어 시각적은 요소에 비교적 덜 영향을 받는 것에 비해 PFE는 심리음향의 특징이 크므로 시각적인 요소에 비교적 큰 영향을 받는다. 귓바퀴의 크기, 위치, 방향, 형태에 따라 편차가 크고 그로 인해 전면, 또는 후면에 대한 소리의 정위감이 모호해지는 경우도 있으므로 더 시각적인 요소에 의존하게 된다. 시각적인 위치와 소리의 정위가 다르면 감각적 이질감과 혼란함이 생기듯 반대로 머리전달함수의 평균화 오류는 시각적인 요소를 부가함으로써 해소할 수 있게 된다.

이처럼 우리의 감각은 상호작용하며 청각적 공간의 지각에서는 시각 요소가, 시각적인 공간의 지각에서는 청각 요소가 감각을 명확하게 할 수 있음을 알 수 있다. 이번 연구는 연기자의 위치에 따라 상호작용하는 감각의 부가로 감성과 몰입을 상승시키고 이를 응용하기 위함이다.

4. 다중감각의 전이를 위한 매개체

4.1. 마이크로소프트 키넥트 뎁스 카메라

애저 키넥트 DK 뎁스 카메라는 마이크로소프트에서 개발한 모션 캡처 카메라로 신체의 골격(skeleton)을 좌우의 위치뿐만 아니라 앞뒤의 깊이(Depth)까지 입체적으로 감지하여 25개 관절의 좌표를 분석할 수 있는 기기이다. 기기부터 신체까지의 거리, 즉 깊이는 적외선을 투광하고 반사되어 돌아오는 시간으로 3D 공간의 위치를 계산한다.

이렇게 분석된 위치 정보는 마이크로소프트에서 제공하는 소프트웨어 개발 키트 SDK에서 각각 X, Y, Z 좌표의 디지털 데이터로 변환된다. 이 정보 중 필요한 신체 관절의 데이터를 OSC(Open Sound Control)나 MIDI 데이터로 변환하여 각종 기기의 컨트롤에 활용할 수 있다.

4.2. 다중감각의 전이에 대한 키넥트 v2 사용의 의의

이번 연구에서 키넥트 v3는 ‘움직임을 보다’라는 시감각의 작용을 공간음향으로 연출된 ‘소리를 듣는다’라는 청감각의 작용으로 전환시키는 역할이다. 이는 기술적 응용 이외에도 미디어아트에서 시도되고 있는 인터렉티브 미디어아트의 예술적 가치와 응용이라는 관점에서 의미가 크다. 기관별로 작용하는 감각을 통합적으로 분석하고 이해하며 이를 전환하는 것은 인간의 뇌에서 일어나는 일이다. 이것을 2장에서 서술한 ‘다중감각의 전이’로 해석하면 멀티미디어기기를 활용하여 이를 기술적으로 구현한다는 것 이상으로 예술적인 가치와 의미를 부여할 수 있다.

| 뇌 | 키넥트 |

| UN 본부가 떠오른다 | 인터렉티브 이미지를 보여준다 |

| Dynamic이 기억난다 | 인터렉티브 사운드를 들려준다 |

| 팬사인회 악수가 기억난다 | 아두이노로 동작을 구현한다 |

| 광고제품의 맛이 기억난다 | 구현 불가능 |

| 광고제품의 향이 기억난다 | 구현 불가능 |

표 5. 다중감각의 전이 및 OSC 전환 비교표

그림 5와 표 5는 외부 자극으로부터 우리의 뇌와 키넥트 v3가 어떻게 감각을 전이, 또는 변환하며 표현하는지를 보여주는 예시이다. 이처럼 키넥트 v3는 우리의 뇌처럼 감각을 전환할 수 있는 매개체라고 할 수 있으며 이를 활용하여 OSC와 같은 데이터를 만들 수 있다.

4.3. OSC 전환을 위한 두번째 매개체 – Ableton LIVE 11

SDK가 제공하는 1차 데이터를 OSC로 변환하기 위해서는 목적에 맞는 별도의 API(Application Programming Interface)가 필요하다. 다행히 DAW 중에 MAX/MSP가 빌트인 되어있고 비교적 쉽게 외부 멀티미디어기기와 연동이 가능한 Ableton의 LIVE 11을 사용하여 키넥트 v3와 연결하였다. LIVE 11을 사용하면 SDK를 입력받아 Max for Live라는 MAX/MSP 애플리케이션의 코딩을 통해 OSC와 MIDI로 변환할 수 있다.5) 그러나 여기서 문제가 발생하였다. 키넥트 v3를 PC에 연결하면 카메라에 장착된 마이크 어레이로 인해 기기 자체가 오디오기기로 인식되어 오디오 출력을 위한RME Fireface800 오디오인터페이스와 동시에 쓸 수 없었다. 둘 중 하나만 선택해야 했다. 오디오인터페이스를 사용하지 않으면 키넥트 v3로 변환한 OSC나 MIDI를 전송할 수가 없다.

4.4. 중간 매개체 Derivative사의 TouchDesigner – OSC 전환 과정의 문제점과 해결 방법

3.3장에서 발생한 문제는 결국 MAX for LIVE를 사용하지 않고 2차 매개체로 Derivative사의 터치디자이너(Touch Designer)6)를 사용함으로써 해결하였다. 이것을 키넥트 v3와 LIVE 11 사이의 매개 코딩 프로그램으로 사용하면 별도의 API 개발이나 코딩 작업 없이 6가지 메인 오퍼레이터(COMP, TOP, CHOP, SOP, MAT, DAT)를 사용하여 노드(Node) 형식으로 조합하고 파라미터값을 조정함으로써 OSC로 변환할 수 있다. 특히, 터치디자이너는 키넥트를 바로 인식할 수 있고 32개의 관절 정보를 실시간으로 출력해 주는 전용 오퍼레이터( kinect v3)가 있어 이것과 조합하여 사용할 수 있다.

5) Max for Live는 Ableton Live11 suite 이상부터 기본 빌트인되어 있는 MAX/DSP 애플리케이션

6) Derivative 사에서 개발한 노드 기반 비주얼 프로그램 언어로 6개의 operator를 조합하여 실시간 대화형 멀티미디어 콘텐츠 개발에 사용

또, 터치디자이너는 기본적으로 Ableton LIVE 11과 OSC를 주고받을 수 있는 TDAbleton팔레트 브라우저(LIVE 11, LIVE 9 & 10)를 기본 제공하고 있다. TDAbleton에서 제공하는 12개의 부속 오퍼레이터로 LIVE의 많은 기능을 컨트롤할 수 있다. 그림 7과 같이 간단하게 키넥트 v2와 LIVE 11을 연결하면 OSC로 LIVE 11을 컨트롤하고 대부분의 기능과 파라미터를 조절할 수 있다. LIVE 11이 실행되어 있으면 TDAbleton 팔레트 브라우저의 TDAbletonPackage를 띄우는 것만으로 아래 그림 7처럼 LIVE 11과 쉽게 연결할 수 있다.

5. 인터렉티브 사운드 발현 및 컨트롤 설계

지금까지의 기술적인 배경과 매개체를 바탕으로 아래에 설정된 예제 미션이 실질적으로 구현되도록 설계하고 이를 구체화하는 과정을 기술해 본다. 그 어떤 것도 직접적으로 개입하지 않고 카메라에 포착된 동작만으로 소리가 발현되도록 구현하는 것이다. 이번 설계는 단순한 동작과 범위 설정에 국한한 것이지만 이를 확장하면 인터렉티브 사운드 연출을 고도화할 수 있고 다양한 분야에 적용할 수 있다.

| 인터렉티브 사운드 미션 |

| 1. 연주자는 가운데 서 있다. 2. 연주자가 오른손을 왼쪽이나 오른쪽으로 뻗으면 소리가 난다.(가운데에 두면 소리가 나지 않는다) 3. 연주자가 왼손을 올리면 음이 높아지고 내리면 낮아진다. 4. 연주자가 움직이면 소리도 따라 움직인다. |

공간음향의 연출과 응용이 목적인 이번 연구에서 위의 미션이 의미하는 것은 첫째, 키넥트의 인터렉션이 최종 OSC로 출력되는 것을 가장 간결하게 효과적으로 설명할 수 있다는 것과 둘째, 직관적인 기술 적용을 쉽게 대체하여 응용할 수 있다는 것이다. 뒤의 5.1에서 구체적으로 기술하겠지만 오브제의 위치에 따라 음원의 위치를 따라 변하게 하는 것은 미션 4번의 트래킹으로 쉽게 설명할 수 있다.

오브제가 어느 위치에 있느냐에 따라 어떤 소리를 발현할 것인지(연기자의 어느 위치에서 큐랩의 음원이 자동으로 실행되는 예시), 어떤 무대기술을 동작시킬 것인지(연기자가 퇴장하면 자동 암전되는 예시)는 미션 2번과 3번으로 응용할 수 있다.

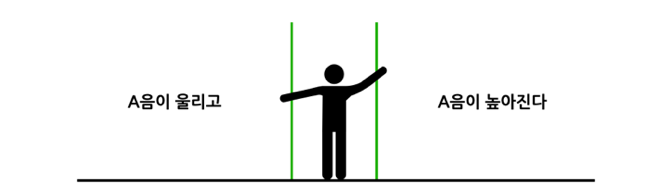

5.1. 인터렉티브 사운드 미션 2 설계

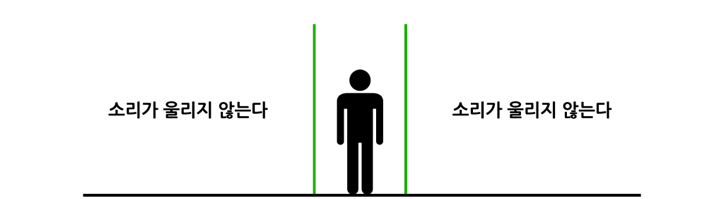

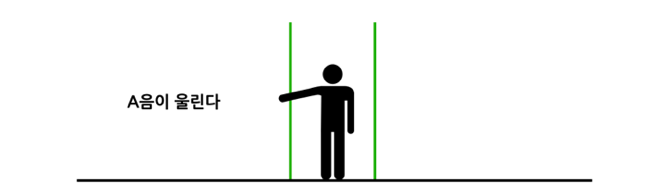

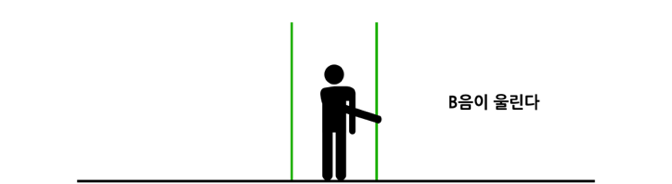

이번에는 미션의 2번 과제를 설계해 본다. 오른손의 위치에 따라 소리가 난다는 것은 연주자의 신체 중 그림 4에서 표시한 32개의 관절 중 특정된 오른손이 미션으로 지정된 위치에 도달했을 때 음이 발현된다는 것을 의미한다. 가로축(X)을 기준으로 3개의 영역으로 분할하고 가운데를 제외한 양옆의 위치에 오른손이 도달했을 때 LIVE 11의 가상악기 음이 울리도록 한다.

그림 8처럼 공간을 세 부분을 나누고 가운데를 제외한 좌우 공간에 보이지 않는 트리거가 설치되어 있어서 오른손이 이곳에 닿으면 소리가 난다고 가정할 수 있다. 그러나 이것은 일반적인 관점이고 기술적인 설계로 구체화하면 물리적인 장막을 설치하여 공간을 구분하지 않더라도, 코딩의 관점으로 따져보면 그림 8처럼 왼손의 트래킹으로 달라지는 좌푯값의 변화를 구분하는 것만으로 공간을 분할할 수 있다.

오른손 관절에 심어진 좌푯값의 범위를 설정하는 것으로 간단하게 해결할 수 있다. 즉, 우리의 일반적인 관점을 어떤 기준점(왼손의 좌표)의 시각으로 보느냐에 따라 간단하게 정리할 수 있게 된다.

| 공간의 수식화 | 결과 |

| Hand_rx< -0.2 | A음이 울린다 |

| -0.2 < Hand_rx < 0.2 | 소리가 울리지 않는다 |

| 0.2 < Hand_rx | B음이 울린다 |

표 6. 공간의 수식화와 결과물 표출

TOP 오퍼레이터 중 Kinect를 실행하면 키넥트 v3가 자동으로 연결되면서 카메라 앞에 있는 신체의 관절 좌표를 실시간으로 전송해 준다. 여기에서 select 오퍼레이터의Channel Names에 P1/hand_r:tx를 입력하면 우리가 원하는 오른손의 가로축(X) 좌표만 추출할 수 있다. 이후 Expression 오퍼레이터로 표6으로 수식화한 X좌표 값의 범위를 Expr0, Expr1, Expr2에 입력하여 공간을 분할한다.

| Expression (X축) | 3분할 공간에 각각 수식화 값 expr입력 |

| Expr0 : me.inputVal<-0.21 | |

| Expr1 : True if (me.inputVal>-0.2 and me.inputVal<0.2) else | |

| Expr2 : True if (me.inputVal>0.21) else |

다음으로 Constant 오퍼레이터를 연결하여 오른손의 위치가 3개 공간의 어디에 있느냐에 따라 각각 일정한 정숫값을 표출하도록 설정한다. -1부터 1까지 변하는 실숫값을 3개의 영역에서 지정된 정숫값 3개로 각각 출력할 수 있다.

예시) -1 ~ -0.21, -0.2 ~ 0.2, 0.21 ~ 1 -> 65, 70, 72

여기까지는 터치디자이너의 TOP 오퍼레이터를 사용한다. 그런데 이것만으로는 소리가 나지 않는다. 이것은 오른손의 위치가 3개의 영역 중 어디에 있느냐, 또는 어느 영역에 닿았느냐에 따라 연주할 음을 지정했다는 뜻이다. 그음을 실제 연주할지 말지는 또 다른 상호작용의 개입이 있어야 한다. 예를 들면 고개를 숙였을 때, 마치 건반을 누르는 것처럼 음이 연주되도록 해야 한다. 다시 말하면 어떤 음을 선택하는 첫 번째 작용과 그음을 눌러서 소리가 나도록 하는 두 번째 작용이 각각 있어야 한다는 뜻이다. 그러나 이것은 간단한 방법이 아니다. 가상악기의 음을 지정하는 것은 TOP 오퍼레이터로 설정할 수 있었지만 TDAblton으로 연결된 LIVE 11의 가상악기의 음이 울리도록 하는 것은 DAT 오퍼레이터 중 CHOP Execute으로 명령해야 한다. 그러나 이종 간의 메인 노드는 링크를 연결하는 방식으로 바로 데이터를 전송할 수 없으므로 파이썬7)의 코딩을 통해 간접적으로 수행해야 한다. (링크 연결 자체가 되지 않는다.)

7) 네덜란드에서 1991년 개발한 객체 지향형 동적 타이핑 프로그래밍 언어

| 음의 발현을 위한 파이썬 코딩 |

| NumChans = {int(op(‘right1’).numChans) def on ValueChange(channel, sampleIndex, val, prev): for n in range (1, NumChans): if op(‘right1’)[0] == 1 and op(‘right’)[4] == 1: op(‘abletonMIDI1’).SendMIDI (‘note’, int(op(‘R_notes1’)[0]). 100) elif op(‘right1’)[0] == 1 and op(‘right’)[5] == 1: op(‘abletonMIDI1’).SendMIDI(‘note’,int(op (‘R_notes1’)[1]). 100) elif op(‘right1’)[0] == 1 and op(‘right’)[6] == 1: op(‘abletonMIDI1’).SendMIDI (‘note’, int (op(‘R_notes1’)[2]). 100) return |

CHOP Execute 오퍼레이터로 코딩한 명령을 통해 그림 8과 같이 오른손의 위치에 따라 공간별로 심어놓은 음을 연주할 수 있게 된다.

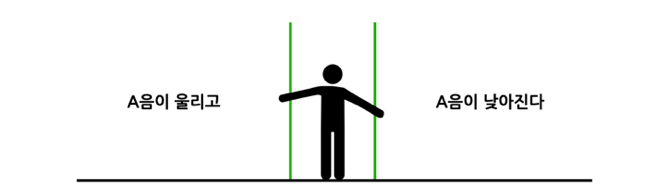

5.2. 인터렉티브 사운드 미션 3 설계

이번에는 미션의 3번 과제를 설계해 본다. 그림 10과 같이 왼손의 높이인 Y축의 변화로 피치밴딩(Pitch banding)을 적용해 본다. 왼손을 수평으로 뻗었을 때의 높이를 0으로 삼고 그보다 높아지면 증가하고 낮아지면 감소하도록 한다. 이것은 왼손의 Y 좌표를 추출하여 가상악기의 피치밴드 휠에 이식하면 된다.

| 높낮이의 수식화 | 결과 |

| 0 < Hand_ly | 음이 높아진다 |

| Hand_ly = 0 | 음의 변화가 없다 |

| Hand_ly < 0 | 음이 낮아진다 |

표 7. 피치벤딩의 수식화와 결과물 표출

음의 높낮이 변화는 MIDI의 컨트롤 중 피치벤드(Pitchbend)를 이용하여 변조한다. 이것도 왼손의 Y좌푯 값에 따라 음의 높낮이가 달라지도록 하기 위하여 math 오퍼레이터를 사용하여 0부터 1까지 변하는 왼손의 Y좌푯값을 range에서 -1부터 1까지 재설정한다.

| 피치벤드 MIDI 데이터 전송을 위한 파이썬 코딩 |

| def onValueChange(channel, sampleIndex, val, prev): op(‘abletonMIDI1’).SendMIDI (‘pitchbend’, val) return |

여기까지 설계가 끝났다면 오른손을 왼쪽이나 오른쪽으로 뻗었을 때 소리가 날 것이고 이때 왼손을 펼쳐 올리거나 내릴 때 음의 피치가 높아지거나 낮아지게 될 것이다.

5.3. 인터렉티브 사운드 미션 4 설계

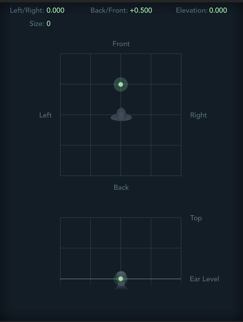

마지막 4번 미션은 그림 13과 같이 25개의 관절 중 머리 좌표로 추출하여 사용한다. 신체의 위치를 머리 좌표로 삼아야 하는 이유는 머리는 몸체에 붙어 있으면서 신체의 가장 높은 위치와 가장 낮은 위치까지 추출하기에 적합하며(서 있을 때와 누워 있을 때의 경우) 팔이나 다리 같은 다른 신체의 변화에 크게 영향을 받지 않으면서도 독립적인 동작을 구사할 수 있기 때문이다.

이것은 별도의 코딩 없이 AbletonMIDI의 부속 오퍼레이터 중 AbletonTrack의 panning 파라미터에 헤드의 X값을 드래그 & 드롭 방식으로 이식하면 머리의 움직임을 그대로 추적하여 위치를 표현해 준다. 높낮이의 변화를 나타내는 Y 값과 깊이를 나타내는 Z값의 파라미터를 추가하여 (X, Y, Z)의 변화로 3D 공간의 위치를 표현한다.

이것으로 미션에 대한 기본적인 설계는 끝난 것이다. 여기까지 완료되었다면 연주자가 오른손을 왼쪽이나 오른쪽으로 뻗었을 때 소리가 날 것이고, 연주자가 왼손을 뻗어 올리거나 내리면 음이 높아지거나 낮아질 것이다. 또, 음이 울리는 동안 연주자가 움직이면 소리도 그대로 따라 움직이게 된다.

참고로 이번 연구에서 인터렉션의 출력 데이터를 MIDI 데이터로 선택한 이유는 대다수의 장비에서 MIDI 입출력 포트를 지원하며 가변 범위가 정숫값으로 정량화8)되어 있어 편집 및 활용에 용이하기 때문이다.

6. 다중감각의 전이와 상호작용의 응용

6.1. 공간음향 연출 응용 – 연기자 움직임에 의한 공간음향 연출 구현

이번에는 공간음향에서 지금까지 연구한 내용이 적용될 수 있는 응용 사례를 기술한다.

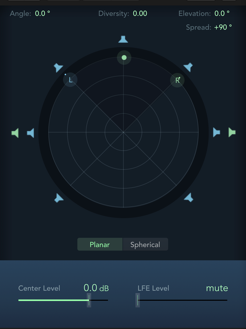

5장에서 설명한 구성에서 공간음향을 구현할 수 있는 애플의 로직 프로 X(이하 로직)를 연결한다. 단, PC에서 두 개의 DAW을 띄울 수 없고 지금까지의 구성은 윈도 OS의 PC에서만 가능9)하므로 별도의 Mac OS PC에서 로직으로 최종 공간음향을 구현한다. 로직은 10.7 버전부터 공간음향을 지원하고 3D 사운드 렌더러를 기본 탑재하고 있으며 에어팟프로10) 이상의 모니터링 기기에서 쉽게 입체음향을 체감할 수 있다.

8) 미디 노트 범위 : 0 ~ 127, 미디 노트 벨로시티 : 0 ~ 127, 미디 콘트롤 번호 : 0 ~ 127, 피치벤드 범위 : 0 ~ 8192

9) 키넥트 v2는 MS 윈도 OS에서만 연결 및 구동이 가능하다.

이번 연구의 인터렉티브 공간음향을 별도의 추가 장비나 서버 없이 구현해 볼 수 있다. 특히, 로직은 수직 각의 변화도 구현할 수 있다. 이것은 일반 스피커로도 수직 각의 변화를 확실히 느낄 수 있을 정도로 PFE의 재현력이 좋으며 UI의 사용이 간편하다. 로직은 오디오 마스터 출력단에 기본적으로 Dolby Renderer를 띄울 수 있다. 또, 트랙별로 오브제의 움직임을 나타낼 수 있는 3D Object Panner로 자유롭게 공간음향을 연출할 수 있다.

이것으로 키넥트를 통해 전달받은 연기자의 X, Y, Z 좌표로 공간음향을 표현한다. 이미 두 오디오인터페이스 간 MIDI 데이터를 주고받을 수 있도록 연결하였으므로 연기자의 좌푯값(X, Y, Z)을 3D Object Panner의 수평 좌표(X, Y)와 수직 좌표(Y)로 연결하여 연기자의 움직임에 따라 사운드의 공간적 정위가 변하도록 한다

10) 애플이 개발한 블루투스 연결 방식의 무선 이어폰. 이 제품 이상부터 애플의 공간음향 기능을 사용할 수 있다.

단, 여기에서 관점의 전환이 필요하다. 움직이는 오브제의 소리를 고정된 청자가 추적하는 관점이 아니라 주어진 공간에서 액티브한 연기자의 소리를 청자가 듣는 관점이므로 그림 1과 같은 수평, 수직, 거리의 방위각 개념이 아닌, 그림 17과 같은 3차원 공간 좌표의 개념이 필요하다. 두 개념의 변수도 다르므로 정확한 위치를 나타내기 위해 구분하여 표현해야 한다.

로직에서 방위각의 좌표 변수를 그림 18처럼 3차원 공간 좌표로 변경해야 한다. 로직에서 채널별로 Binaural Panner에서 3D Object Panner로 변경해야 키넥트의 좌표와 정확하게 일치하게 된다. 변수는 각각 다음과 같이 치환된다.

| Binaural Panner | 3D Object Panner |

| Elevation | Object Position Elevation |

| Angle | Object Position Left/Right |

| Diversity | Object Position Back/Front |

이렇게 바꾸면 그림 19처럼 연기자의 움직임에 따라 소리가 그대로 따라 움직이게 된다. 키넥트 쪽 PC에서 넘어온 MIDI 데이터를 로직의 3D Object Panner의 3가지 변수에 이식하는 것은 MIDI Learnig 기능을 사용한다.

이것은 단순히 음원의 패닝을 연기자의 좌표에 연동시키는 것에 그치지 않고 그림 20과 같이 연기자의 마이크로 입력되는 소스에 대해서도 트랙킹 되어 패닝이 적용되며 녹음되는 동안 오토메이션도 그대로 그림 19와 같이 생성된다. 이것을 라이브 실황 녹음 음원에 적용할 수 있다.

또, 영상과 매칭된 사운드의 정위감을 향상할 수 있으며 기록된 오토메이션을 포스트에서 수정할 수도 있다. 실험을 통해 좌우, 앞뒤, 상하의 움직임이 스피커로 출력됨을 확인하였다. 이것을 뮤지컬의 연기자 움직임에 연동시키면 효과가 더 높아진다. 연기자 머리의 위치에 따라 높낮이 변화도 그대로 Elevation Factor로 표현할 수 있으며 관객은 전면의 스피커로 일치화된 감각적 변화를 체감할 수 있으므로 감흥과 몰입을 높일 수 있다.

6.2. 하드웨어 제어 응용 – 연기자의 위치와 움직임에 의한 AV하드웨어 제어

5장에서 시연한 것처럼 위치별로, 동작 별로 공연의 연출에 의한 하드웨어 작동을 제어할 수 있다. 연기자의 동작에 맞춰 플레이되어야 하는 큐에 약간의 지연(현장에서는 이를 마라고 부른다)이라도 생기게 되면 전체적인 흐름과 몰입을 방해할 수 있다.

무용 공연인 경우 무용수의 느낌과 해석에 따라 안무, 시간, 동선이 매번 달라질 수 있으므로 사전에 합을 맞췄다고 해도 정확하게 큐를 플레이하기가 어려울 수 있다. 이럴 때 특정 위치와 특정 동작에 QLAB(이하 큐랩)의 큐를 실행하도록 심어 놓을 수 있다. 그림 21처럼 PC 내의 애플리케이션 간은 OSC나 스크립트로 연결하여 컨트롤할 수 있고 네트워크 스위처로 연결된 외부 기기는 이더넷으로 컨트롤할 수 있다12).

11) 12)우성민, “OSC·AppleScript를 활용한 공연장 AV 시스템 통합 제어에 관한 연구”, 국내석사학위논문 상명대학교 일반대학원, 2023.서울, 24, 39-55

앞서 설명한 대로 지금까지는 음악감독이 공연에 맞춰 큐랩을 플레이했지만 이번에는 그림 22과 같이 키넥트로 입력되는 연기자의 위치와 동작만으로 플레이되도록 해본다.

| 인터렉티브 무대기술 연출 미션 |

| 1. 연기자가 입장하면 음악 1번이 플레이 된다(A). 2. 연기자가 B에서 왼팔을 옆으로 뻗으면 음악 2번이 플레이 된다.(B) 3. 연기자가 B에서 오른팔을 올리면 조명이 점점 밝아지고 내리면 어두워진다.(B) 4. 연기자가 퇴장하면 음악 2번이 서서히 줄어든다.(C) |

이번 미션에 5.1장과 5.2장에서 구현했던 기술을 적용할 수 있다. 큐랩에서 위 미션을 큐로 만든다.

13) 0이 아닌 1의 값인 이유는 등장하면서부터 음악이 플레이되도록 하기 위함. 0인 경우 입장하는지 아닌지 알 수가 없다.

연기자가 입 퇴장하면서 음악이 실행되고 종료되는 것은 X 좌푯값으로 간단하게 설정할 수 있다. 일반적인 미디 패닝은 63을 센터로 잡고 왼쪽 끝을 0으로 시작해서 오른쪽 끝이 127이 되므로 이 값으로 연기자의 X 좌푯값을 큐랩의 트리거에 입력하면 다른 변수에 상관 없이 A와 B를 쉽게 구성할 수 있다.

이번에는 B의 위치를 특정한다. 머리의 좌표가 이 영역에 있을 때 왼팔과 오른팔에 따라 다음 동작을 하게 된다.

5.1장에서 공간을 분할한 방법대로 범위를 특정한다. 이 영역에 있을 때 일정한 값이 출력되도록 하고 그 값을 미디 노트에 할당하여 큐랩의 트리거에 입력하여 완성한다.

연기자 B 위치에서 오른팔을 올리고 내릴 때 -> Dim 100 ~ 0%14)

이번에는 B의 위치에서 왼팔을 펼쳤을 때 즉, 왼손이 B를 벗어나 무대 하수 쪽으로 침범했을 때 음악 2가 플레이되도록 설정한 미디 노트를 할당한다.

모든 설정이 끝났으면 음악감독이 GO를 누르지 않더라도 연기자가 무대 하수로 입장하여 연기를 하고 B에서 동작한 후 무대 상수로 퇴장하는 인터렉티브 무대기술 연출이 자동으로 실행된다.

7. 고찰 및 결론

예술의 표현으로 전달되는 다중감각은 그것이 일치되었을 때 기억력이 높아지며, 불일치되었을 때 스트레스 지수가 높아진다.15) 다중감각의 일치화는 관객의 감흥과 몰입을 오래 지속시켜 결과적으로 예술의 목적과 가치를 높이게 된다. 기술을 개발하고 향상하고 적용하는 것은 궁극적으로 본연의 목적과 가치를 높이기 위해 존재하는 것이다.

마이크로소프트에서 개발한 키넥트는 다원 예술, 미디어아트, 영상 제작, 게임 제작, 가상현실 연구, 멀티미디어, 의료, 건축 등 다양한 분야에 활용되고 있다. 이번 연구는 다중감각의 전이와 상호작용에 대한 개념 이해, 공간음향의 효과적인 연출과 무대기술의 응용, 그리고 관객의 감흥과 몰입을 높이기 위한 방법이 무엇인지에 대한 고찰이다.

감상은 예술의 아름다움을 느끼고 이해하고 즐기는 일련의 과정이며, 예술작품과 예술 활동은 관객의 감상을 통해 완성된다. ![]()

14) Dim의 가변은 MIDI 신호를 Grand MA3 조명 컨트롤러와 직접 연결하는 방식으로 터치디자이너에서 데이터를 직접 전송(적용 방법은 5.2장 참고)

15) 허재원. “사운드의 공감각과 영상 이미지와의 일치감이 기억에 미치는 영향.” 국내 석사학위논문 명지대학교 대학원, 2018. 서울

참고문헌

1. 강성훈, 강경욱, 입체음향, 기전연구사 (1997.7)

2. 강성훈(1995), 디지털 오디오와 심리음향, 전자공학회지, 22(5), 518-528.

3. 우성민, “OSC·AppleScript를 활용한 공연장 AV 시스템 통합 제어에 관한 연구”, 국내석사학위논문 상명대학교 일반대학원, 2023.서울

4. 최찬규, 이머시브 라이브 시스템 패닝 알고리즘, (사)무대음향협 회(2022.04), SSM Vol.02, 54-72

5. 양원영.(2018).[용어와 건축] 공감각, 그리고 다중감각의 상 호작용.건축

6. 윤홍노.(1970). 공감각 은유의 구조성 -현대 한국시를 중심으로. 국어국 문학, 49·50, 183-200.

7. 허재원. “사운드의 공감각과 영상 이미지와의 일치감이 기억에 미치는 영향.” 국내석사학위논문 명지대학교 대학원, 2018. 서울

8. 조엘 살리나스, 정유선(번역), 거울촉각 공감각, 성안당(2019.1)